Datenschutz & KI managen: Risikoanalyse nach EU AI Act

Wenn ein KI-System im Recruiting nur Männer für Führungspositionen empfiehlt, liegt der Fehler meist nicht in der Technik – sondern in den Trainingsdaten. Um den Konsequenzen solcher Bias entgegenzuwirken, hat die Europäische Union den EU AI Act beschlossen: Unternehmen sollen nicht nur funktionierende, sondern verantwortbare und faire KI einsetzen.

Doch wie gelingt das, ohne Prozesse auszubremsen oder sich im Paragrafendschungel zu verlieren? Der Druck, künstliche Intelligenz im Unternehmen einzusetzen, wächst – ob im Personalmanagement, in der Kundenkommunikation oder zur Effizienzsteigerung. Gleichzeitig werden die Anforderungen durch den EU AI Act und die DSGVO immer komplexer. Die Folge: Unsicherheit. Was ist erlaubt? Was muss dokumentiert werden? Und wer trägt die Verantwortung?

In der neuen Folge unseres Podcasts „Ausgesprochen digital“ geht es um genau diesen Spagat – und darum, wie Unternehmen mit einer strukturierten Risikobewertung nicht nur gesetzliche Vorgaben erfüllen, sondern auch echte Handlungssicherheit gewinnen.

Im Gespräch mit Kerstin Harzendorf zu Datenschutz & KI

Kerstin Harzendorf ist erfahrene Juristin und Expert Consultant für Datenschutz bei der Telekom MMS und berät Unternehmen bei der praxisnahen Umsetzung datenschutzrechtlicher Anforderungen. Mit einem starken Fokus auf die Schnittstelle zwischen der Datenschutz-Grundverordnung und der KI-Verordnung unterstützt sie Geschäftskunden bei der risikobasierten Integration von Datenschutz in komplexe IT- und KI-Projekte.

Im Podcast bringt sie ihre fundierte Erfahrung aus der entwicklungsbegleitenden Beratung sowie aus der Durchführung von Datenschutz-Folgenabschätzungen ein. Ihr Ziel: datenschutzkonforme Digitalisierung gestalten und Risiken frühzeitig managen, um Grundrechte zu schützen.

- Tags: KI, KI-System, Risikobewertung, EU AI Act, DSGVO

- Dauer der Folge: 22:30 Min

- Transkript: >barrierefreies PDF (92 KB)

EU AI Act und DSGVO: Zwei Regelwerke, ein Ziel

Der EU AI Act – im Deutschen bekannt als die "Verordnung über künstliche Intelligenz" – ist die erste umfassende Regulierung für KI-Systeme innerhalb der Europäischen Union. Sie soll sicherstellen, dass KI-Systeme – gerade dann, wenn sie über Menschen entscheiden oder auf sensible Daten zugreifen – nachvollziehbar, kontrollierbar und sicher betrieben werden. Und: Dass die Grundrechte der betroffenen Personen gewahrt bleiben.

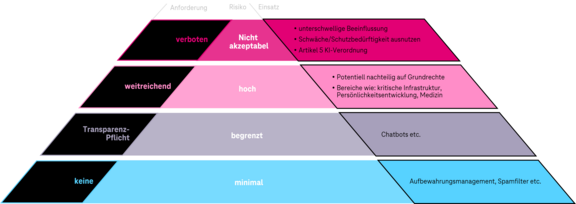

Die KI-Verordnung teilt KI-Systeme in vier Risikoklassen ein. Je höher das potenzielle Risiko eines KI-Systems, desto umfangreicher sind die regulatorischen Anforderungen, die Unternehmen erfüllen müssen. Dies reicht von vollständigen Verboten über strenge Prüf- und Dokumentationspflichten bis hin zu einfachen Transparenzanforderungen oder gar keiner Regulierung bei minimalem Risiko.

Die EU-KI-Verordnung (EU AI Act) klassifiziert KI-Systeme und allgemeine KI-Modelle anhand ihres Risikoniveaus und Verwendungszwecks.

Die Anforderungen der KI-Verordnung gelten zusätzlich zur Datenschutz-Grundverordnung (DSGVO). Und das hat Konsequenzen: Sobald personenbezogene Daten verarbeitet werden – und das ist bei den meisten KI-Systemen der Fall –, greifen automatisch auch die Grundsätze des Datenschutzes.

Dabei geht es nicht darum, das Rad neu zu erfinden. Viele Unternehmen verfügen bereits über bewährte Datenschutzprozesse. Die Herausforderung liegt nun darin, diese Prozesse gezielt um die Anforderungen des AI Acts zu erweitern – etwa im Hinblick auf Fairness, Grundrechte und die Nachvollziehbarkeit von Entscheidungen.

Besonders bei Hochrisiko-KI ist es wichtig, bestehende Datenschutz-Folgenabschätzungen (DSFA) um eine Grundrechtsbewertung zu ergänzen. Denn wenn KI-Systeme im Hintergrund Empfehlungen aussprechen, die über Ablehnung, Bewertung oder Auswahl entscheiden, müssen Unternehmen transparent darlegen können, wie diese Ergebnisse zustande gekommen sind – und auf welchen Daten sie beruhen.

Managen Sie Risiken frühzeitig mit einer strukturierten Risikobewertung.

Managen Sie Risiken frühzeitig mit einer strukturierten Risikobewertung.

Unsere Experten unterstützen Sie mit individueller Datenschutzberatung und Risikobewertung für den verantwortungsvollen Einsatz von künstlicher Intelligenz.

Zur DatenschutzberatungSo funktioniert eine Risikobewertung – in fünf Schritten

Im Alltag zeigt sich oft: Compliance-Risiken entstehen nicht durch bösen Willen, sondern durch fehlende Transparenz in Datenflüssen, unklare Verantwortlichkeiten oder mangelnde Dokumentation. Deshalb ist es entscheidend, frühzeitig Standards zu definieren – zum Beispiel für Trainingsdaten, Modellentscheidungen oder Zugriffsrechte. Unternehmen sollten nachvollziehbare Prüfpfade schaffen und Zuständigkeiten klar verankern: Wer überwacht? Wer dokumentiert? Wer greift ein, wenn etwas schiefläuft?

Unternehmen müssen deshalb wissen, welche ihrer KI-Anwendungen als „Hochrisiko“ eingestuft werden – und wie sie diesen gerecht werden. Dies klingt zwar nach Aufwand, dient aber vor allem der Risikominimierung und Zukunftssicherung.

Viele Unternehmen stehen nun aktuell erstmals vor der Herausforderung, eine fundierte Risikobewertung für KI-Systeme durchzuführen. Dabei geht es nicht nur um Compliance, sondern vor allem um eine praxisnahe Grundlage für verantwortungsvolle Entscheidungen.

Ja, oft wird der Datenschutz so als Showstopper gesehen und wir antworten dann immer gerne: dafür haben Sie uns. Wir machen das nämlich aus Leidenschaft. Also keine Angst vor roten Risiken. Kerstin Harzendorf, Expert Consultant Privacy

Datenschutzrisiken beim Einsatz von KI werden in der Regel in mehreren Schritten erfasst und bewertet:

- Zieldefinition und Use Case verstehen

Zunächst wird genau geklärt, welche KI-Anwendung eingesetzt werden soll und zu welchem Zweck. Geht es um ein Empfehlungssystem, ein Recruiting-Tool oder einen intelligenten Assistenten? Welche Daten fließen ein – und wie wird damit umgegangen? - Risiken identifizieren

Ausgehend vom Use Case wird ein Risiken-Katalog entwickelt. In der Praxis können das zwischen 80 und 100 Einzelszenarien sein – etwa der unbeabsichtigte Datenabfluss, fehlerhafte Entscheidungslogiken, oder Diskriminierung durch fehlerhafte Trainingsdaten. - Risiken bewerten

Diese Risiken werden gemeinsam mit den Fachbereichen nach Eintrittswahrscheinlichkeit und Schadenshöhe bewertet. Das Ergebnis: ein Ampelsystem aus grünen, gelben und roten Risiken. - Maßnahmen ableiten

Welche Risiken sind tragbar, welche müssen durch technische oder organisatorische Maßnahmen reduziert werden? Und wo ist der geplante KI-Einsatz unter den aktuellen Bedingungen vielleicht nicht vertretbar? Für kritische Risiken (rot) müssen sofortige Lösungen her. Bei moderaten Risiken (gelb) kann ein begleitender Monitoring-Prozess helfen. Technische Maßnahmen wie Verschlüsselung oder Anonymisierung können ebenfalls das Risiko reduzieren. - Evaluation und Lifecycle-Management

Eine Risikobewertung ist kein einmaliger Akt. Gerade bei Hochrisiko-KI fordert der AI Act eine kontinuierliche Neubewertung – zum Beispiel wenn sich die Technologie oder die Rahmenbedingungen ändern.

Ein gutes Risikomanagement funktioniert wie ein Frühwarnsystem – es schützt nicht nur vor Sanktionen, sondern auch vor Reputationsschäden und Vertrauensverlust.

Praxisbeispiel: Bias im Recruiting

Ein besonders anschauliches Beispiel für den Einsatz von Hochrisiko-KI ist der Recruitingprozess. Viele Personalabteilungen setzen auf KI-gestützte Software, um Bewerbungen effizienter und objektiver zu bearbeiten – etwa durch automatisierte Vorauswahl. Die Hoffnung: mehr Fairness, weniger subjektive Verzerrung. Doch genau in diesem sensiblen Bereich zeigen sich die systematischen Risiken besonders deutlich.

Wenn eine KI mit historischen Daten trainiert wurde, in denen etwa Frauen oder Menschen mit Migrationshintergrund seltener in Führungspositionen vertreten waren, übernimmt die Software diese Muster – und verstärkt bestehende Strukturen statt sie aufzubrechen. Solche Verzerrungen, auch Bias genannt, führen dazu, dass die KI diskriminierende Muster reproduziert, selbst wenn die Entwickler dies nicht beabsichtigt haben.

Dabei geht es nicht nur um technische Fragen, sondern um Fairness, Transparenz und Nachvollziehbarkeit: Unternehmen müssen erklären können, wie KI-gestützte Entscheidungen zustande kommen und auf welchen Daten sie beruhen. Der EU AI Act verlangt deshalb zu Recht eine Hochrisiko-Einstufung solcher Systeme – nicht um Innovation zu verhindern, sondern um sicherzustellen, dass ihre Wirkung verstanden und ihre Risiken aktiv gesteuert werden.

Praxisbeispiel: KI im Bildungsbereich

Im Podcast wird auch das Bildungswesen als ein zentraler Anwendungsbereich für KI beleuchtet – mit großem Potenzial, aber ebenso großen Herausforderungen. KI-basierte Lernsoftware kann gezielt zur individuellen Förderung eingesetzt werden, etwa indem sie den Lernfortschritt von Schüler*innen analysiert und darauf abgestimmte Inhalte bereitstellt.

Gerade angesichts von Fachkräfte- und Lehrermangel bietet das enorme Chancen. Gleichzeitig stuft der EU AI Act den Einsatz von KI im Bildungsbereich als Hochrisiko ein – und das aus gutem Grund: Es geht um den Schutz von Minderjährigen, um die Wahrung von Chancengleichheit und um die Vermeidung von Profiling oder übermäßiger Überwachung.

Wichtig sei deshalb, klare Grenzen zu ziehen, zum Beispiel durch begleitende Prozesse, die sicherstellen, dass KI-Systeme nicht in Notenvergabe oder Leistungsbewertungen eingreifen. Auch müsse ausgeschlossen werden, dass emotionale Zustände analysiert oder personenbezogene Daten zu anderen Zwecken weiterverwendet werden. Ziel ist eine unterstützende, nicht überwachende Technologie – mit dem Menschen im Mittelpunkt.

DSGVO und KI kombinieren: Was Privacy-Enhanced Technologies (PETs) leisten können

Die KI-Verordnung ist erstmal technikneutral und soll den Fortschritt nicht verhindern – im Gegenteil: Sie fordert vielmehr, datenschutzfreundliche Technologien einzusetzen. Ein wichtiger technischer Ansatz, um das Spannungsfeld zwischen Datenschutz und dem Bedarf an Trainingsdaten für KI zu entschärfen, sind Privacy-Enhanced Technologies (PETs). Das sind Verfahren zur Anonymisierung, Pseudonymisierung oder Aggregation von Daten. Diese ermöglichen es, personenbezogene Informationen so zu verarbeiten, dass sie nicht ohne Weiteres zurückverfolgt werden können und somit keine Risiken von KI für sensible Daten oder personenbezogene Daten entstehen oder diese minimiert werden.

Das kann gerade dann hilfreich sein, wenn Unternehmen ihre Daten für KI-Training oder Weiterentwicklung bereitstellen wollen, ohne gegen Datenschutzvorgaben zu verstoßen. Diese Maßnahmen sollten nicht nur Aufgabe der KI-Anbieter sein: Unternehmen selbst sollten prüfen, wie sie Daten schon vor der Weitergabe absichern oder anonymisieren können – zum Beispiel durch eigene technische Vorverarbeitung. Das reduziert Risiken und schafft gleichzeitig die Grundlage für eine verantwortungsvolle KI-Nutzung.

Strukturen schaffen, Vertrauen gewinnen: So bringen Sie DSGVO und KI in Einklang

Die KI-Verordnung bringt Ordnung ins komplexe Feld der künstlichen Intelligenz – mit klaren Vorgaben, die Planungssicherheit schaffen. Wer jetzt in Transparenz, dokumentierte Abläufe und aktives Risikomanagement investiert, legt das Fundament für vertrauenswürdige und wettbewerbsfähige KI-Anwendungen. Die Verbindung von Datenschutz und KI-Risikobewertung zeigt: Mit klaren Prozessen und definierten Zuständigkeiten lässt sich Innovation nicht nur kontrollieren, sondern gezielt gestalten.

Wer verstehen will, wie das praktisch gelingt, bekommt in der Podcast-Folge konkrete Antworten, mit dem nötigen Blick auf das, was zählt: Klarheit, Struktur – und Handlungsspielraum.

Moderiert wird diese Folge von Steffen Wenzel, Mitgründer und Geschäftsführer von politik-digital und Stefanie Liße, Senior Sales Managerin bei Telekom MMS.

Dies ist die zweite Folge unserer Podcast-Staffel zum EU AI Act. Zuvor haben wir uns bereits mit der Einordnung und den Grundlagen der KI-Verordnung befasst. In der nächsten Folge geht es darum, wie Unternehmen ihre Mitarbeitenden auf diesem Weg mitnehmen: durch gezielte Weiterbildung, praktische Tools und mehr Verständnis für die Arbeitsweise von KI.

Weiterführende Inhalte/mehr zum Thema

- EU AI Act: Was die neue KI-Verordnung für Unternehmen bedeutet – und wie Telekom MMS jetzt unterstützt | Unternehmensnews vom 17.06.2025

- Trustworthy AI - Verantwortungsvoll mit künstlicher Intelligenz umgehen | Das Thema vertrauenswürdige KI im Fokus